LG AI연구원, 병리 이미지로 암 진단하는 AI 모델 발표

LG AI연구원 이 차세대 정밀 의료 AI 모델 ‘엑사원 패스(EXAONE Path) 2.0’을 공개했다.

이 모델은 고해상도 병리 조직 이미지 분석만으로 유전자 변이 여부를 예측해 암 진단 시간을 기존 2주에서 1분 이내로 줄일 수 있는 기술로 평가받고 있다.

엑사원 패스 2.0은 지난해 8월에 발표한 1.0 버전과 올해 6월 세계 최대 종양학 학술대회인 ASCO 2025에서 소개된 1.5 버전에 이어 공개된 최신 버전이다.

이 모델은 오는 22일 열리는 ‘LG AI 토크콘서트 2025’에서 정식으로 발표될 예정이다.

이번에 발표된 엑사원 패스 2.0은 멀티오믹스(Multiomics) 기반 데이터 학습을 통해 질병 원인과 유전자 발현 정보를 정밀 분석할 수 있는 AI 기반 의료 솔루션이다.

DNA, RNA 등 다양한 생체 정보를 포함한 데이터를 병리 조직 이미지와 함께 학습시켜 기존 유전체 분석의 한계를 극복하는 데 집중했다.

기존에는 병리 이미지를 작은 조각으로 분할해 분석하는 패치 단위 처리 방식이 일반적이었으나, 이 방식은 특정 세포만 분석해 전체 맥락을 놓치는 ‘특징 붕괴’ 현상이 발생하는 문제가 있었다.

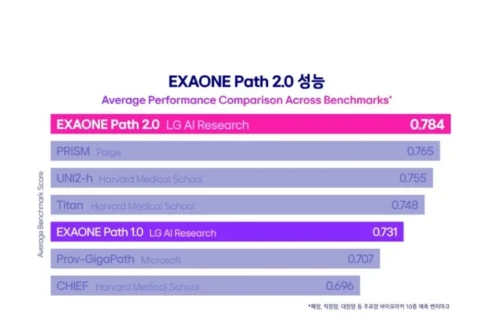

엑사원 패스 2.0은 패치 이미지와 전체 슬라이드 이미지를 함께 학습하는 알고리즘을 적용해 이 문제를 해결했으며, 유전자 변이 예측 정확도를 78.4%까지 끌어올렸다.

이는 하버드 메디컬스쿨의 모델 정확도인 75.5%보다 높은 수치다.

엑사원 패스 2.0은 1만 장 이상의 병리 이미지와 유전자 정보가 쌍을 이루는 대규모 데이터를 기반으로 학습되었으며, 고가의 유전체 검사를 대체할 수 있는 정밀 분석 도구로 주목받고 있다.

의사들은 조직 표본 이미지 분석만으로도 특정 유전자 변이 여부를 빠르게 확인할 수 있어 치료 속도와 정확도 모두를 높일 수 있다.

LG AI연구원 은 이번 모델을 활용해 폐암, 대장암 등 주요 암종에 특화된 AI 솔루션도 별도로 개발했다.

특정 암종에 최적화된 특화 모델은 불필요한 검사를 줄이고, 표적 치료 가능성이 높은 환자군을 조기에 식별하는 데 기여할 수 있다는 설명이다.

또한 LG AI연구원은 미국 밴더빌트대학교 메디컬 센터 황태현 교수팀과 손잡고 세계 최고 수준의 멀티모달 의료 AI 플랫폼 공동 개발에도 착수했다.

기존 의료 AI가 실험실 단계를 벗어나지 못하는 현실에서, 임상 현장에서 실제로 작동하는 AI를 구현하겠다는 계획이다.

이 프로젝트는 단순한 기술 개발이 아니라, 실제 암 환자들의 병리 이미지, 유전자 정보, 치료 결과 데이터를 실시간으로 반영해 AI 알고리즘을 학습시킨다는 점에서 차별화된다.

병원은 이 AI를 통해 실시간 조직검사 결과를 분석해 맞춤형 치료 전략을 수립할 수 있고, 제약사는 AI를 활용해 임상시험에 적합한 환자군을 조기에 확보할 수 있어 신약 개발 기간과 비용을 획기적으로 줄일 수 있을 것으로 기대된다.

황 교수는 “우리가 개발하는 AI 플랫폼은 신약 개발의 전 과정을 혁신하는 게임 체인저가 될 것”이라고 말했다.

이어 “임상시험 중 실시간 수집되는 환자의 데이터를 분석해 어떤 환자가 특정 치료에 반응하지 않으면 빠르게 치료 방법을 바꾸고 효과가 가장 좋은 치료제를 실시간으로 제공할 수 있다”고 덧붙였다.

배동현 (grace8366@sabanamedia.com) 기사제보